制約なし凸最適化問題に対する勾配降下法と目的関数に強凸性を仮定するときの収束解析をまとめる

本記事は以下の過去記事の内容を用います.

制約なし凸最適化問題の目的関数に強凸性を仮定することの意味について考える - エンジニアを目指す浪人のブログ

降下法の枠組みと,厳密直線探索,バックトラッキング直線探索の概要をまとめる - エンジニアを目指す浪人のブログ

勉強を進めていて,制約なし凸最適化問題に対する勾配降下法(gradient descent method)(最急降下法と呼ばれることの方が多いようです),とくに目的関数に強凸性を仮定するときの収束解析について興味を持ったので,内容をまとめておくことにしました.Boyd and Vandenberghe(2004)の9章3節(の1)をベースにしています.

=================================================================================

目次

0. 準備

1. 勾配降下法

1.1. アルゴリズム

2. 勾配降下法の収束解析

2.1. 勾配降下法と強凸性の仮定による不等式

2.2. 厳密直線探索

2.3. バックトラッキング直線探索

[ 0. 準備 ]

冒頭の過去記事(制約なし凸最適化問題の目的関数)[ 0. 準備 ]と同じです.

冒頭の過去記事(降下法の枠組み)の内容も必要です.

[ 1. 勾配降下法 ]

[ 1.1. アルゴリズム ]

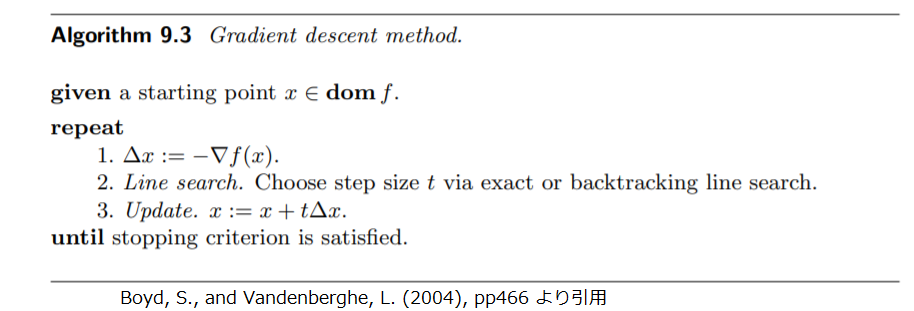

探索方向 の自然な選択は負の勾配です.そのようなアルゴリズムを勾配法(gradient algorithm)あるいは勾配降下法(gradient descent method)といいます.

(1.1.1)

このとき以下を得ます.勾配降下法(1.1.1)は でないかぎり冒頭の過去記事(降下法の枠組み)(1.1.6)すなわち降下法であるための必要条件をみたしていることがわかります.

(1.1.2) (1.1.1)

勾配降下法のアルゴリズムを以下に示します.厳密直線探索(exact line search)とバックトラッキング直線探索(backtracking line search)は冒頭の過去記事(降下法の枠組み)にあります.

よく用いられる停止条件は小さい正の整数を として

の形式です.ほどんどの実装において,この条件はステップ1の後に判定されます.

[ 2. 勾配降下法の収束解析 ]

目的関数に強凸性を仮定し,厳密直線探索あるいはバックトラッキング直線探索と組み合わせるときの勾配降下法の収束について調べていきます.

[ 2.1. 勾配降下法と強凸性の仮定による不等式 ]

目的関数 は

で強凸であると仮定します.すると以下をみたす

が存在します.冒頭の過去記事(制約なし凸最適化問題の目的関数)(1.3.1)です.

(2.1.1)

以下のステップサイズ の関数

を定義します.

(2.1.2)

強凸性を仮定することにより得られる不等式である冒頭の過去記事(制約なし凸最適化問題の目的関数)(1.2.2)で, として以下を得ます.

は

の二次関数により上から抑えられることを意味します.

(2.1.3)

(2.1.2)

(2.1.3)(※)

(2.1.3)(※※)

[ 2.2. 厳密直線探索 ]

勾配降下法(1.1.1)を用いるとします. を最小化する

は以下です.この操作は、厳密直線探索(冒頭の過去記事(降下法の枠組み)(1.2.1)です)を行うことに相当します.

(2.2.1)

(2.1.2)

(2.2.2)

以下を定義します.

(2.2.3)

ここで(2.1.3)(※※)の左辺を として最小化し,右辺を

の二次関数なので

として最小化して以下を得ます.

(2.2.4)

(2.2.2)

冒頭の過去記事(降下法の枠組み)(1.1.2)

冒頭の過去記事(制約なし凸最適化問題の目的関数)(1.1.5)

(2.2.3)

冒頭の過去記事(降下法の枠組み)(1.1.1)(1.1.2)

(2.2.4)(※)

これより について以下が成り立ちます.

(2.2.5)

したがって の十分条件となる厳密直線探索と勾配降下法の反復回数

の下界は高々以下の回数です.

(2.2.6)

両辺とも正

より

(2.2.6)(※)

(2.2.6)(※)の分子 は初期の準最適性(すなわち

と

のギャップ)の最期の準最適性(

より小さい)に対する比の対数をとったものです.この項により,反復回数の下界は,初期点

がどの程度良い点であるか(初期点が良いほど回数が少なくて済む),最終的に必要な精度はどれくらいか(必要な精度が悪いほど回数が少なくて済む),に依存することがわかります.

(2.2.6)(※)の分母 は(2.2.3)より

の関数です.これは冒頭の過去記事(制約なし凸最適化問題の目的関数)(1.3.13)より行列

の条件数の上界,あるいは同記事(1.3.10)より劣位集合

の条件数の上界です.その上界

が非常に大きいとすると

は非常に小さく,このとき以下を得ます.

(2.2.7)

(2.2.3)

の原点まわりのテイラー展開

したがって反復回数 の下界は

の増加に伴い近似的に線形に増加します.

の条件数が

の近くで大きいとき,必要とされる反復回数は大きくなります.逆に,

の劣位集合が等方的であり条件数の上界

が比較的小さいとき,

は小さくなるので(2.2.4)(※)はこのとき収束が速いことを示しています.

(2.2.4)(※)は が等比数列と同じ速さで零に収束することを示しています.数値計算における反復法の文脈において,これを一次収束(linear convergence)といいます.

[ 2.3. バックトラッキング直線探索 ]

勾配降下法とバックトラッキング直線探索を用いるとします.この設定の下,バックトラッキング直線探索の停止条件は以下です(冒頭の過去記事(降下法の枠組み)(1.3.1)にあります).

(2.3.1)

(1.1.1)

(2.1.2)

以下を準備します.

(2.3.2)

勾配降下法と目的関数 の強凸性を仮定することにより得られる不等式(2.1.3)より以下を得ます.ただし

とします.

(2.3.3) (2.1.3)(※)

(2.3.2)

冒頭の過去記事(降下法の枠組み)Algorithm 9.2より

これはバックトラッキング直線探索の停止条件(2.3.1)と同じものです.したがって となったときバックトラッキング直線探索は終了します.ここで,バックトラッキング直線探索が

で終了せず

で終了するとします.このとき以下を得ます.

(2.3.4)

したがってバックトラッキング直線探索は あるいは

のどちらかのとき終了します.(2.3.3)と冒頭の過去記事(降下法の枠組み)(1.1.2)より以下を得ます.

(2.3.5)

(2.3.6)

併せると以下を得ます.

(2.3.7)

冒頭の過去記事(制約なし凸最適化問題の目的関数)(1.1.5)

以下を定義します.(2.2.3)と同じ記号ですが許容します.

(2.3.8)

したがって前節の(2.2.4)(※)とほぼ同じ以下を得ます.したがって前節(2.2.5)以下にある収束に関する議論と類似した議論が可能です.

(2.3.9)

=================================================================================

以上,制約なし凸最適化問題に対する勾配降下法と目的関数に強凸性を仮定するときの収束解析をまとめました.

参考文献

[1] Boyd, S., and Vandenberghe, L. (2004), Convex Optimization, Cambridge University Press.

[2] Mathematics Stack Exchange https://math.stackexchange.com/questions/3256340/why-does-the-gradient-descent-backtracking-line-search-terminate-when-t-ge-be